支持在日常电脑上进行AI聊天会话

功能介绍

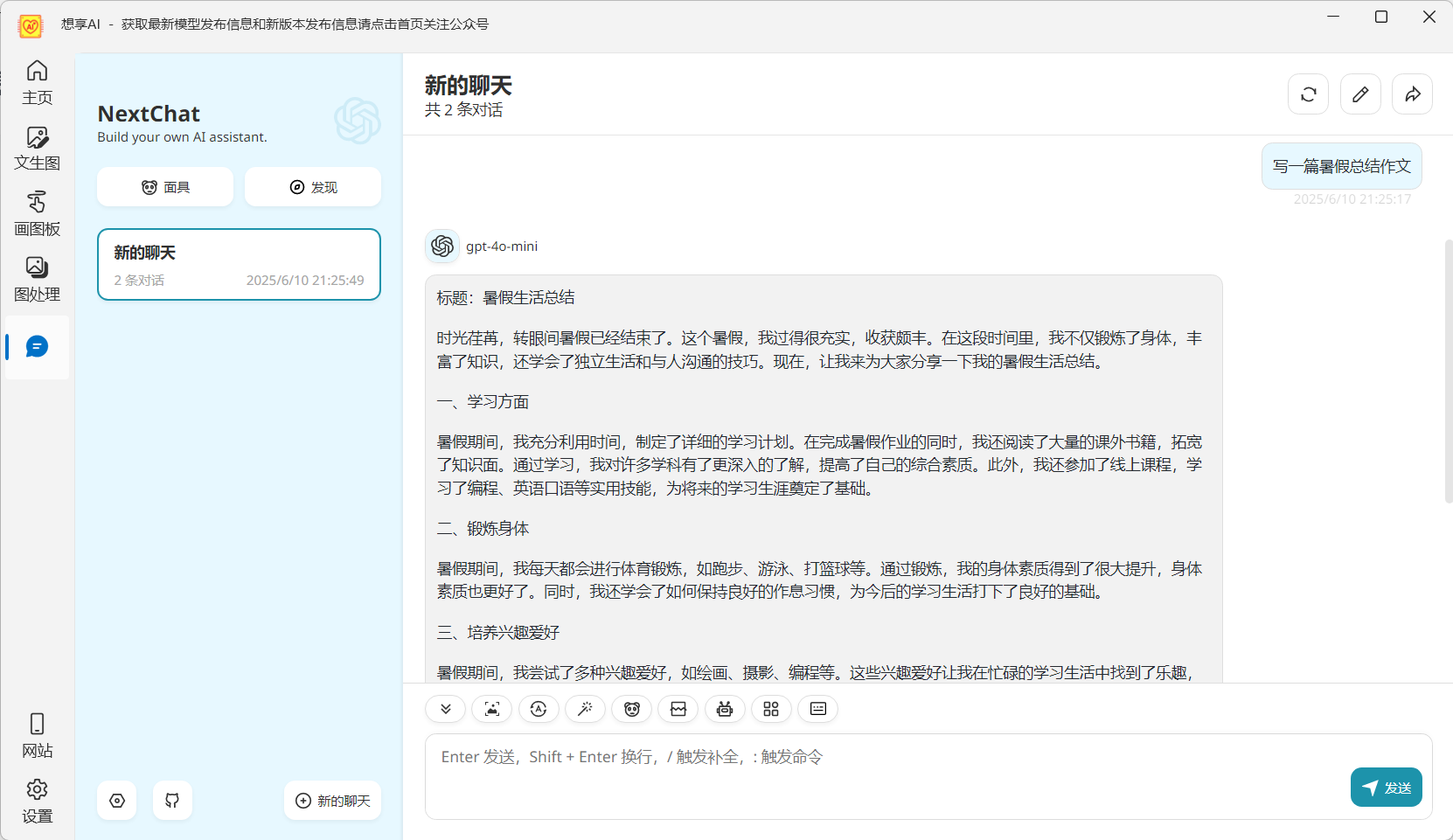

AI聊天功能介绍

利用最新AI大语言模型技术开发,支持各种LLM大模型,操作简单方便,日常电脑可用,无需GPU显卡和配置各种Python环境

生成速度快

采用llama.cpp模型加速技术,可使用CPU在消费级电脑上运行大语言模型

安装使用简单

无需python,没有复杂操作,安装操作简便,支持中英文

硬件要求低

无需显卡,桌面电脑可用,4-8G内存即可,支持显卡生成

本地生成无限制

本地离线聊天,完全自主使用,生成无限制

如何下载和使用想享AI

步骤 1: 软件下载

本软件为桌面软件,可下载软件运行时和安装包,直接点击下一步进行安装,操作简单方便

步骤 2: 模型下载

AI聊天需要下载LLM大语言模型,模型通常都比较大,支持通过网盘下载各种模型。可关注想享AI公众号获取模型发布信息

步骤 3: 加载模型

大语言模型下载后,在软件首页添加相应模型,然后选择模型进行加载。模型较大的话加载时间较长,加载完成后即可开始聊天

开始使用!

常见问题

想享AI使用常见问题

如何下载使用

请分别下载想享AI软件和各种大语言模型,模型下载到软件模型目录即可,软件首次生成时会自动加载

支持哪些模型

软件支持Deepseek和Qwen3等各种大语言模型,支持llama.cpp量化模型

为何加载失败

加速模型使用的底层加速技术有最低CPU要求,需要安装所需运行时

生成文本怎么调整参数

软件支持大语言模型生成的各种高级选项,可调整提示词和其它高级选项进行调整

想享AI

日常电脑可用的免费大语言模型聊天软件,支持CPU和显卡聊天